Professors

Chairholder

Prof. Dr. Stefan Eicker

- Room:

- R09 R02 H33

- Phone:

- +49 201 18-34082

- Fax:

- +49 201 18-34021

- Email:

- Stefan.Eicker (at) paluno.uni-due.de

- Consultation Hour:

- Mo 2pm-3pm; please email for appointments

- Address:

- Universität Duisburg-Essen, Campus Essen

Fakultät für Informatik

Lehrstuhl für Wirtschaftsinformatik und Softwaretechnik

Universitätsstr. 9

45141 Essen

Curriculum Vitae:

- April 2004: Vocation to the chair of business informatics and software engineering at the University of Duisburg-Essen

- October 2003 - July 2004: Associate Professor at the technical University of Clausthal

- November 1997: Vocation to the chair of business informatics and business communication systems at the University of Essen

- 1997: State doctorate and served as an Assistant professor at the European University Viadrina in Frankfurt (Oder)

- 1996 - 1997: Held professorship at the business informatics and communication systems at the University of Essen

- 1995 - 1996: Provisional professorship for the chair of business informatics at the University of Münster

- 1992: Graduation at the University of Dortmund

- 1990-1995: Executive and academic council for the institute of business informatics at the University of Münster

- 1985 - 1990: Research Associate at the chair of business informatics at the department of economic science and social science at the University of Dortmund (chair holder: Prof. Dr. Karl Kurbel)

Publications:

- Eicker, Stefan; Woroch, Robert; Strobel, Gero: Wertgenerierung in Plattformökonomien und Determinanten zur Werteerstellung und -erfassung - Festschrift für Prof. Dr. Stephan Zelewski. In: Schütte, Reinhard; Hohmann, Susanne; Krol, Bianca; Peters, Malte L. (Ed.): Produktions- und Informationsmanagement. Springer Gabler, Wiesbaden 2024, p. 505-531. doi:10.1007/978-3-658-46113-3_20Full textCitationAbstractDetails

Digitale Plattformen haben sich dank ihres disruptiven Potenzials als führende Geschäftsmodelle in einer Vielzahl von Branchen etabliert. Dieser Beitrag beleuchtet die Entwicklung der Ökosystem-Metapher von ihren Ursprüngen bis zu ihrer Anpassung an den digitalen Wandel und diskutiert drei unterschiedliche Perspektiven auf moderne Unternehmensökosysteme. Darüber hinaus werden zentrale Treiber der Wertschöpfung in der Plattformökonomie vorgestellt, die als Instrumente zur Steuerung der Wertgenerierung dienen. Abschließend wird ein Ausblick auf zukünftige Forschungsfelder zur Wertschöpfung in plattformbasierten Ökosystemen gegeben.

Digital platforms have emerged as leading business models across a wide range of industries due to their disruptive potential. This article examines the development of the ecosystem metaphor from its origins to its adaptation to digital change and discusses three different perspectives on modern business ecosystems. In addition, key drivers of value creation in the platform economy are presented, which serve as instruments for managing value generation. The article concludes with an outlook on future fields of research on value creation in platform-based ecosystems.

- Eicker, Stefan; Strobel, Gero; Brogt, Tobias: Smart Service. In: Kollmann, T.; Kuckertz, A.; Stöckmann, C. (Ed.): Gabler Kompakt-Lexikon Unternehmensgründung. Springer Gabler, Wiesbaden 2021. doi:10.1007/978-3-658-30901-5_19CitationDetails

- Eicker, Stefan; Strobel, Gero: Backend as a Service (BaaS). In: Kollmann, T.; Kuckertz, A.; Stöckmann, C. (Ed.): Gabler Kompakt-Lexikon Unternehmensgründung. Springer Gabler, Wiesbaden 2021. doi:10.1007/978-3-658-30901-5_2CitationDetails

- Eicker, Stefan; Brogt, Tobias; Strobel, Gero: Smart Product. In: Kollmann, T.; Kuckertz, A.; Stöckmann, C. (Ed.): Gabler Kompakt-Lexikon Unternehmensgründung. Springer Gabler, Wiesbaden 2021. doi:10.1007/978-3-658-30901-5_19CitationDetails

- Loose, Nils; Thommessen, Christian; Mehlich, Jan; Derksen, Christian; Eicker, Stefan: Unified Energy Agents for Combined District Heating and Electrical Network Simulation. In: Sustainability, Vol 12 (2020) No 21, p. 9301. doi:10.3390/su12219301CitationAbstractDetails

A sustainable and climate-friendly energy supply needs flexible and efficient distribution systems. Key factors to implement this kind of systems are intelligent coordination (smart grid approaches) and the integration of different energy sectors. This article introduces the unified energy agent as an agent-based approach for a comprehensive modelling and control of energy conversion systems. This approach enables both the simulation and optimization of coupled energy networks, and then in a next step, the development of corresponding smart grid solutions to be applied in the field. Its applicability for the simulation of coupled networks is presented by a real-world use-case of an innovative combined heat and electrical network, which was implemented for the city of Lemgo, Germany. Preliminary results from the project are discussed and an outlook on future work is given.

- Schiller, Barbara; Brogt, Tobias; Schuler, J. Peter M.; Strobel, Gero; Eicker, Stefan: Identifying Quality Factors for Self-Tracking Solutions: A Systematic Literature Review. In: Proceedings of the 53nd Hawaii International Conference on System Sciences. Hawaii, USA 2020. doi:10.24251/HICSS.2020.452CitationAbstractDetails

Self-tracking solutions have become globally widespread, as they promise numerous advantages (e.g. improving health) to their users. Despite their benefits, such solutions are often abandoned due to quality issues. This phenomenon can also be observed for digitized products in general. As self-tracking solutions are hybrid products, combining digital and physical components, traditional domain-independent and abstract quality models like the prominent ISO 25000 standard seem to not cover quality in an appropriate way. We address these issues by answering the research question of which factors affect quality perceptions of different stakeholder groups when interacting in a wearable ecosystem. We use a systematic literature review based on a research protocol to identify and analyze 98 quality-influencing factors from 19 studies that we cluster in a map. The identified factors are compared to the ISO 25000 standard, showing that certain factors like hedonic motivation are unconsidered thoroughly in the existing standard.

- Schiller, Barbara; Brogt, Tobias; Schuler, J. Peter M.; Strobel, Gero; Eicker, Stefan: Identifying Quality Factors for Self-Tracking Solutions: A Systematic Literature Review. In: Proceedings of the 53nd Hawaii International Conference on System Sciences. Hawaii, USA 2020. doi:10.24251/HICSS.2020.452CitationAbstractDetails

Self-tracking solutions have become globally widespread, as they promise numerous advantages (e.g. improving health) to their users. Despite their benefits, such solutions are often abandoned due to quality issues. This phenomenon can also be observed for digitized products in general. As self-tracking solutions are hybrid products, combining digital and physical components, traditional domain-independent and abstract quality models like the prominent ISO 25000 standard seem to not cover quality in an appropriate way. We address these issues by answering the research question of which factors affect quality perceptions of different stakeholder groups when interacting in a wearable ecosystem. We use a systematic literature review based on a research protocol to identify and analyze 98 quality-influencing factors from 19 studies that we cluster in a map. The identified factors are compared to the ISO 25000 standard, showing that certain factors like hedonic motivation are unconsidered thoroughly in the existing standard.

Die Bedeutung von sog. Cloud-Services hat in den vergangenen Jahren deutlich zugenommen. Hiermit einher gehen unterschiedlichste Zweifelsfragen und Auseinandersetzungen mit der Finanzverwaltung im Rahmen von Betriebsprüfungen. Dies ist der Tatsache geschuldet, dass regelmäßig große Unsicherheit auf drei Ebenen besteht: Es ist erstens für die Steuerabteilung oder den Berater nur schwer nachvollziehbar, welche konkreten Leistungen sich hinter einem Begriff wie “Cloud-Aufwendungen” verbergen und wie diese Leistungen technisch erbracht werden. Auf einer zweiten Ebene herrscht regelmäßig Unsicherheit im Hinblick auf die zivilrechtliche Kategorisierung entsprechender Verträge und Leistungsbeziehungen. Schließlich ist auf einer dritten Ebene regelmäßig unklar, wie sich die steuerliche Behandlung darstellt. Das kann unter anderem Themen wie Quellensteuereinbehalt/beschränkte Steuerpflicht, die Hinzurechnungsbesteuerung oder auch die gewerbesteuerliche Hinzurechnung betreffen. Der vorliegende Beitrag widmet sich letzterer und hierbei insbesondere der sog. Infrastructure as a Service (IaaS) als einer wesentlichen Art von Cloud-Diensten.

In recent years, the “Internet of Things” with so called “smart products” has obtained increasingpopularity in both practice and research. By building on the capabilities of smart products, servicestransform to “smart services” emphasizing the value smart products can provide and how it is co- created. Even though first attempts have been conducted to conceptualize and classify smart services, there seems to be no overall consensus on the specific characteristics of smart services, which different forms they can take on and how different smart services can be described. For example, existing research on smart services does not always consider the common service design elements “servicecontent” and “service delivery”. To address this shortcoming, we develop a taxonomy of smart services by applying extant literature. We further demonstrate the usefulness of our taxonomy by classifying 50 empirical objects and presenting three cases. As a contribution, the paper enhances the understanding of the notion of smart services and strengthens the conceptual foundation for future smart service research.

- Brogt, Tobias; Eicker, Stefan: Einsatz von Servicesystemen zur Umsetzung von Innovationen im Kontext der Digitalisierung. In: Kollmann, Tobias (Ed.): Handbuch Digitale Wirtschaft. Springer Gabler, Wiesbaden 2019. doi:10.1007/978-3-658-17345-6_82-1Full textCitationAbstractDetails

Durch die Digitalisierung befinden sich Unternehmen oftmals in der Umstellung zu digitalen Geschäftsprozessen und Geschäftsmodellen. Dies bietet viele neue Chancen für Innovationen durch den Einsatz neuer Konzepte und Technologien. Um diese Chancen nutzbar zu machen, können Servicesysteme eingesetzt werden. Der Beitrag gibt einen Überblick über dieses Konzept und zeigt auf, wie Servicesysteme charakterisiert und entworfen werden können. Ein Servicesystem stellt ein soziotechnisches System dar, das auf die Unterstützung der gemeinsamen Wertschöpfung abzielt, indem verschiedene interne und externe Ressourcen integriert und kombiniert werden. Der Entwurf erfolgt im Rahmen des Service Systems Engineerings in meist agilen Prozessen mit dem Ziel einer frühen Markterprobung. Dabei kann der Innovationsgedanke explizit berücksichtigt werden. Vorhandene Entwurfsansätze sind jedoch meist abstrakt und daher weniger für den konkreten Entwurf geeignet. Es können daher wesentliche Faktoren identifiziert werden, die die Entwicklung von Servicesystemen beeinflussen. Der Beitrag schafft einen Überblick über den aktuellen Stand der Forschung und zeigt Ansatzpunkte für eine Verbesserung der Nutzbarmachung des Konzeptes Servicesystem.

- Strobel, Gero; Paukstadt, Ute; Becker, Jörg; Eicker, Stefan: Von smarten Produkten zu smarten Dienstleistungen und deren Auswirkung auf die Wertschöpfung. In: HMD Praxis der Wirtschaftsinformatik, Vol 56 (2019) No 3, p. 494-513. doi:10.1365/s40702-019-00520-xFull textCitationAbstractDetails

Im Rahmen der Digitalisierung nehmen smarte Produkte und die darauf aufbauenden intelligenten Dienstleistungen einen immer größeren Platz sowohl im betrieblichen Kontext als auch im Endkundenbereich ein. Auslöser hierfür stellt vor allem die leistungsfähigere und kostengünstigere Hardware dar, welche es Unternehmen ermöglicht, zunehmend Produkte mit intelligenten und vernetzten Komponenten auszustatten. Diese smarten Produkte bieten Unternehmen und Kunden völlig neue Möglichkeiten zur Interaktion, bieten neue Mehrwerte und beeinflussen die unternehmerische Wertschöpfung an sich. Ziel dieses Beitrages ist es, einen Einstieg in das Themenfeld der smarten Produkte und Dienstleistungen zu geben und aufzuzeigen, welche Möglichkeiten diese für den Endnutzer und für Unternehmen eröffnen.

- Paukstadt, Ute; Strobel, Gero; Eicker, Stefan; Becker, Jörg: Smart Services und ihr Einfluss auf die Wertschöpfung und Geschäftsmodelle von Unternehmen. In: Kollmann, Tobias (Ed.): Handbuch Digitale Wirtschaft. Springer Gabler, Wiesbaden 2019, p. 1-21. doi:10.1007/978-3-658-17345-6Full textCitationAbstractDetails

In den letzten Jahren wurde die Digitalisierung verstärkt vor dem Hintergrund desInternets der Dinge betrachtet, bei dem jegliche Bestandteile des täglichen Lebens zu intelligenten Objekten (Smart Products) werden und mit dem Internet verbunden sind. Aufbauend auf den Smart Products entstehen neue digitale Dienstleistungen, sogenannte Smart Services. Mit diesen intelligenten Dienstleis- tungen werden völlig neue Wertschöpfungspotenziale erschlossen, die sich eben- falls auf die Geschäftsmodelle von Unternehmen auswirken. Ziel dieses Beitrages ist es, einerseits einen allgemeinen Einstieg in den Themenkomplex der Smart Services zu bieten und selbige andererseits spezifisch vor dem Hintergrund ihres Wertschöpfungspotenzials für Geschäftsmodelle und Ökosysteme näher zu beleuchten.

Today, value is co-created in sociotechnical systems in which different stakeholders integrate resources (products and services) in an interactive process. For these systems to be successful, quality is very important. However, existing systems often fail to deliver the right level of quality, and the available quality approaches seem to be insufficient. Therefore, this paper provides insight into the role of quality by applying a service system perspective. We show that a holistic quality perception that reflects the modern expectations of stakeholders is necessary. In addition, different resources for modern services and their interaction need to be taken into account. This results in the need for quality management specific for sociotechnical systems, which integrates different existing approaches to cover these demands. Furthermore, the authors suggest future research on perceived quality and technical support in this context.

Today, value is co-created in sociotechnical systems in which different stakeholders integrate resources (products and services) in an interactive process. For these systems to be successful, quality is very important. However, existing systems often fail to deliver the right level of quality, and the available quality approaches seem to be insufficient. Therefore, this paper provides insight into the role of quality by applying a service system perspective. We show that a holistic quality perception that reflects the modern expectations of stakeholders is necessary. In addition, different resources for modern services and their interaction need to be taken into account. This results in the need for quality management specific for sociotechnical systems, which integrates different existing approaches to cover these demands. Furthermore, the authors suggest future research on perceived quality and technical support in this context.

- Schwittek, Widura; Eicker, Stefan: A study on third party component reuse in Java enterprise open source software. In: Kruchten, Philippe; Giannakopoulou, Dimitra; Tivoli, Massimo (Ed.): CBSE '13 Proceedings of the 16th International ACM Sigsoft symposium on Component-based software engineering. ACM, New York, NY, USA 2013, p. 75-80. doi:10.1145/2465449.2465468Full textCitationAbstractDetails

Recent studies give empirical evidence that much of today's software is to a large extent built on preexisting software, such as commercial-off-the-shelf (COTS) and open source software components. In this exploratory study we want to contribute to this small but increasing body of knowledge by investigating third party component reuse in 36 Java web applications that are open source and are meant to be used in an enterprise context. Our goal is to get a better understanding on how third party components are reused in web applications and how to better support it.

The results are in line with existing research in this field. 70 third party components are being reused on average. 50 percent of the 40 most reused third party components are maintained by the Apache Foundation. Further research questions based on the study results were generated and are presented at the end of this paper.

- Schwittek, Widura; Eicker, Stefan: Decision Support for Off-The-Shelf Software Components in Web Development. In: Michael Grossniklaus, Manuel Wimmer (Ed.): Current Trends in Web Engineering. Springer, Berlin, Heidelberg 2012, p. 238-243. doi:10.1007/978-3-642-35623-0_26CitationAbstractDetails

Reusing off-the-shelf (OTS) components (including commercial and open source software) has become a key success factor in software development projects leading to reduced costs, faster time-to-market and better software quality. This especially holds true in the field of web engineering, where software engineers are faced with a steady proliferation of new technologies and standards. But there are upfront and ongoing efforts and risks attached to the adoption of OTS components which makes decision-making very difficult. Such difficulties are for example a large and intransparent market, incompatibilities between components and architectural mismatches. In this paper, a plan towards a novel platform concept is proposed that can improve the situation for software engineers coping with the adoption of OTS components during webbased systems development.

One key contribution is an empirically derived ontology to describe software artifacts on a feature level allowing a better description and identification of OTS components in the domain of web development. Another key contribution is a concept for a lean experience sharing mechanism. The goal of both contributions is to improve OTS component decision-making.

The concept will be implemented as a platform prepopulated with OTS components from the domain of Java web development. A cross-case study is planned to evaluate the concept.

- Schwittek, Widura; Diermann, André; Eicker, Stefan: A Guidance Model for Architecting Secure Mobile Applications. In: Schmidt, Andreas U.; Russello, Giovanni; Krontiris, Ioannis; Lian, Shiguo (Ed.): Security and Privacy in Mobile Information and Communication Systems. Springer, Berlin, Heidelberg 2012, p. 12-23. doi:10.1007/978-3-642-33392-7CitationAbstractDetails

In addition to fast technological advances in the area of mobile devices and its broad adoption in todays developed societies, mobile applications do not only address the consumer electronics market but are also increasingly being used in a business and industry context. Thus, we see a demand for research developing software systems comprising mobile devices with special respect to security concerns. In this paper we want to address this demand from an architectural point of view and make use of the concept of architectural decisions. We present a guidance model that supports on the one hand this decision-making process during architecting mobile applications. On the other hand the presented guidance model serves as a tool to evaluate existing architectures. The guidance model has been created based on an adapted version of Zimmermann’s SOAD framework, which is used for in the context of service-oriented architectures. The guidance model itself consists of a set of interrelated architectural decisions for recurring design situations. The application of the guidance model is demonstrated along a real-world scenario. The guidance model also takes into account that security concerns are changing and therefore provides an extension mechanism which is presented in this paper.

- Schwittek, Widura; Schmidt, Holger; Beckers, Kristian; Eicker, Stefan; Faßbender, Stephan; Heisel, Maritta: A Common Body of Knowledge for Engineering Secure Software and Services. In: Proceedings of the 7th International Conference on Availability, Reliability and Security. IEEE, 2012, p. 499-506. doi:10.1109/ARES.2012.31Full textCitationAbstractDetails

The discipline of engineering secure software and services brings together researchers and practitioners from software, services, and security engineering. This interdisciplinary community is fairly new, it is still not well integrated and is therefore confronted with differing perspectives, processes, methods, tools, vocabularies, and standards. We present a Common Body of Knowledge (CBK) to overcome the aforementioned problems. We capture use cases from research and practice to derive requirements for the CBK. Our CBK collects, integrates, and structures knowledge from the different disciplines based on an ontology that allows one to semantically enrich content to be able to query the CBK. The CBK heavily relies on user participation, making use of the Semantic MediaWiki as a platform to support collaborative writing. The ontology is complemented by a conceptual framework, consisting of concepts to structure the knowledge and to provide access to it, and a means to build a common terminology. We also present organizational factors covering dissemination and quality assurance.

- Beckers, Kristian; Eicker, Stefan; Faßbender, Stephan; Schmidt, Holger; Heisel, Maritta; Schwittek, Widura: Ontology-Based Identification of Research Gaps and Immature Research Areas. In: Quirchmayr, Gerald; Basl, Josef; You, Ilsun; Xu, Lida; Weippl, Edgar (Ed.): Multidisciplinary Research and Practice for Information Systems. Springer, Berlin, Heidelberg 2012, p. 1-16. doi:10.1007/978-3-642-32498-7_1CitationAbstractDetails

Researchers often have to understand new knowledge areas, and identify research gaps and immature areas in them. They have to understand and link numerous publications to achieve this goal. This is difficult, because natural language has to be analyzed in the publications, and implicit relations between them have to be discovered. We propose to utilize the structuring possibilities of ontologies to make the relations between publications, knowledge objects (e.g., methods, tools, notations), and knowledge areas explicit. Furthermore, we use Kitchenham’s work on structured literature reviews and apply it to the ontology. We formalize relations between objects in the ontology using Codd’s relational algebra to support different kinds of literature research. These formal expressions are implemented as ontology queries. Thus, we implement an immature research area analysis and research gap identification mechanism. The ontology and its relations are implemented based on the Semantic MediaWiki+ platform.

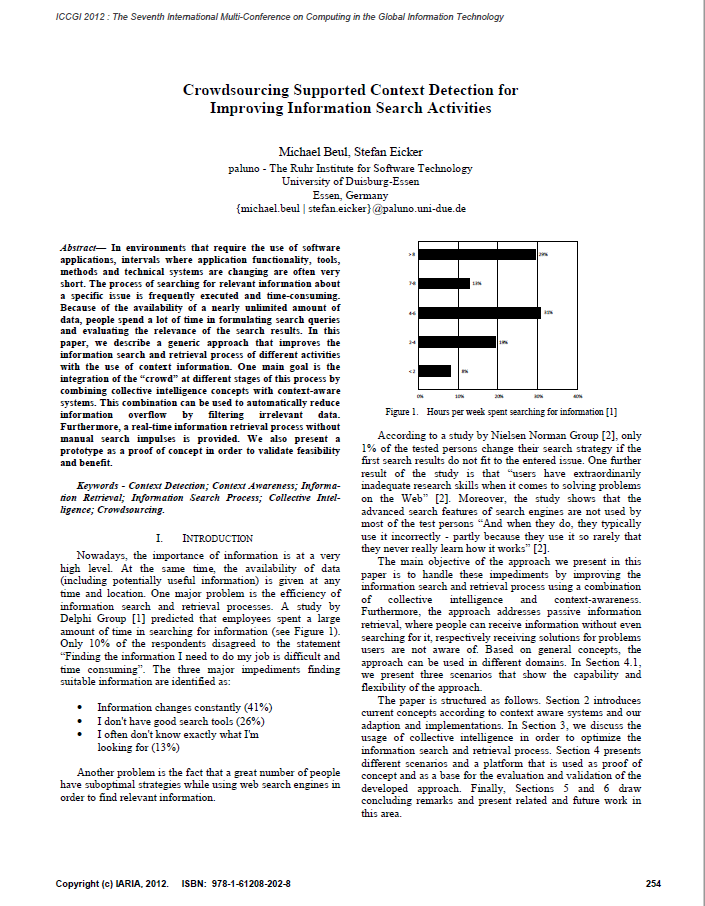

- Beul, Michael; Eicker, Stefan: Crowdsourcing Supported Context Detection for Improving Information Search Activities. In: International Academy, Research; Association, Industry (Ed.): Proceedings of The Seventh International Multi-Conference on Computing in the Global Information Technology. (to be published), 2012, p. 254-259. CitationAbstractDetails

In environments that require the use of software applications, intervals where application functionality, tools, methods and technical systems are changing are often very short. The process of searching for relevant information about a specific issue is frequently executed and time-consuming. Because of the availability of a nearly unlimited amount of data, people spend a lot of time in formulating search queries and evaluating the relevance of the search results. In this paper, we describe a generic approach that improves the information search and retrieval process of different activities with the use of context information. One main goal is the integration of the crowd at different stages of this process by combining collective intelligence concepts with context-aware systems. This combination can be used to automatically reduce information overflow by filtering irrelevant data. Furthermore, a real-time information retrieval process without manual search im pulses is provided. We also present a prototype as a proof of concept in order to validate feasibility and benefit.

- Ueberschär, Bernd; Schwittek, Widura; Eicker, Stefan; Bourimi, Mohamed; Heupel, Marcel; Kesdogan, Dogan: Mobile applications for the angling community - Supporting Biodiversity research in FishBase. In: 6th World Recreational Fishing Conference (WRFC), August, 1-4, 2011. Berlin, Humboldt-Univ. 2011. CitationDetails

- Brunnert, Andreas; Eicker, Stefan; Schuler, Peter M.: Managing Secure System Architectures for Mobile Enterprise Applications. In: Weghorn, H.; Azevedo, L.; Isaías, P. (Ed.): Proceedings of the IADIS International Conference Applied Computing 2011. IADIS, Rio de Janeiro, Brasilien 2011, p. 131-138. doi:10.13140/2.1.5016.2562CitationAbstractDetails

Due to increasing spread of mobile equipment many companies face the opportunity to supply their employees with mobile enterprise applications. Since a 'mobile enterprise application' is not (!) just a 'mobile' enterprise application the selection of a suited system architecture is not trivial. Mobile enterprise applications entail different requirements (esp. concerning security), different platforms and different concepts for management. The paper analyses distinct requirements of mobile enterprise applications, discusses concepts for managing mobile enterprise applications and evaluates major mobile platforms. Thus companies get empowered to select a suited combination of platform and architecture that support the security and management requirements for their mobile enterprise application.

- Eicker, Stefan; Schuler, Peter M.: Visualizing Variability in Business Process Variant Models. In: Weghorn, H.; Azevedo, L.; Isaías, P. (Ed.): Proceedings of the IADIS International Conference Applied Computing 2011. IADIS, Rio de Janeiro, Brasilien 2011, p. 323-330. Full textCitationAbstractDetails

In the area of business process management, mastering variability is as important as handling re-use. This paper presents

an approach for annotating business process model activities with variant indicating attachments. Thereby, maintaining

business process variant models will become more convenient since the modeler gets presented alternatives for the

current business process model on the basis of an underlying reference process model – but without the complexity of

reference modeling itself. The presented annotation is independent of a distinct process modeling notation and works

across several views of business processes. - Schwittek, Widura; Schmidt, Holger; Eicker, Stefan; Heisel, Maritta: Towards a Common Body of Knowledge for Engineering Secure Software and Services. In: Joaquim Filipe, Kecheng Liu (Ed.): Proceedings of the International Conference on Knowledge Management and Information Sharing. SciTePress - Science and Technology Publications, Paris 2011, p. 369-374. doi:10.5220/0003666303690374CitationAbstractDetails

Interdisciplinary communities involve people and knowledge from different disciplines in addressing a common challenge. Differing perspectives, processes, methods, tools, vocabularies, and standards are problems that arise in this context. We present an approach to support bringing together disciplines based on a common body of knowledge (CBK), in which knowledge from different disciplines is collected, integrated, and structured. The novelty of our approach is twofold: first, it introduces a CBK ontology, which allows one to semantically enrich contents in order to be able to query the CBK in a more elaborate way afterwards. Second, it heavily relies on user participation in building up a CBK, making use of the Semantic MediaWiki as a platform to support collaborative writing. The CBK ontology is backed by a conceptual framework, consisting of concepts to structure the knowledge, to provide access options to it, and to build up a common terminology. To ensure a high quality of the provided contents and to sustain the community’s commitment, we further present organizational means as part of our approach. We demonstrate our work using the example of a Network of Excellence EU project, which aims at bringing together researchers and practitioners from services computing, security and software engineering.

- Belter, Roman; Spies, Thorsten; Ludwig, Andre; Franczyk, Bogdan; Eicker, Stefan: Towards Information Transparency in the Context of Service Management. In: Proceedings of the IEEE International Conference on Service-Oriented Computing and Applications (SOCA), 2010. IEEE, Perth 2010. doi:10.1109/SOCA.2010.5707164Full textCitationAbstractDetails

With an increasing demand for higher value services, comprehensive support for service customization, provisioning and management is needed. This paper details ongoing research work regarding a service management approach, which supports the handling of service artifacts during the service lifecycle. The approach introduces an information model for e-Service Management, as well as a tailored view concept to provide individual views to participating stakeholders. The outlined approach tackles nonfunctional management issues which lead to better maintainable, adaptable and extendable service systems.

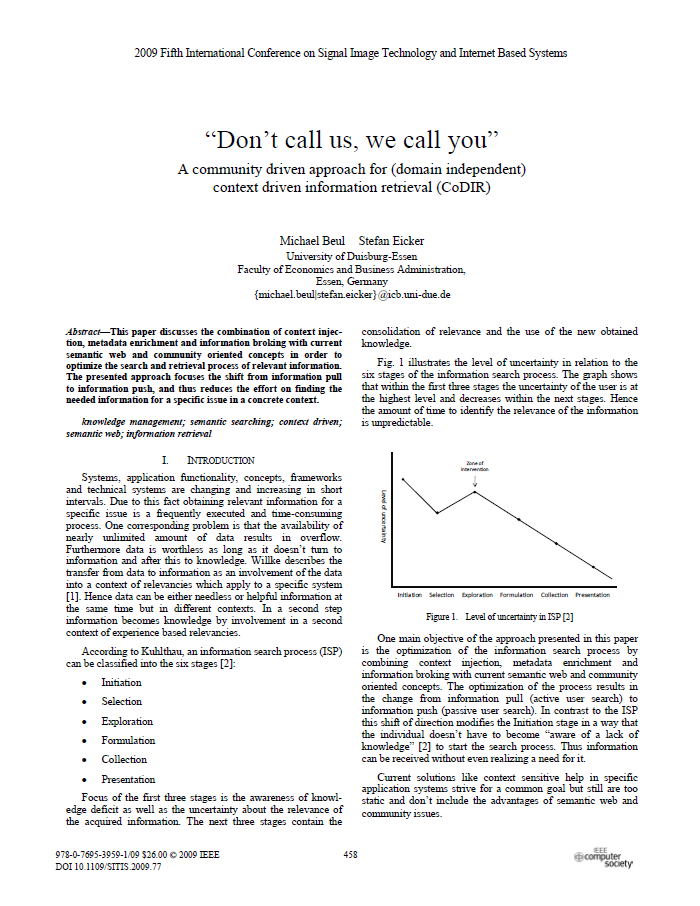

- Beul, Michael; Eicker, Stefan: "Don't Call Us, We Call You" - A Community Driven Approach for (Domain Independent) Context Driven Information Retrieval (CoDIR). In: Yetongnon, Kokou; Chbeir, Richard; Dipanda, Albert (Ed.): The Fifth International Conference on Signal Image Technology & Internet Based Systems - SITIS 2009. IEEE Computer Society, Marrakesh, Morocco 2010, p. 458-464. doi:10.1109/SITIS.2009.77CitationAbstractDetails

This paper discusses the combination of context injection, metadata enrichment and information broking with current semantic web and community oriented concepts in order to optimize the search and retrieval process of relevant information. The presented approach focuses the shift from information pull to information push, and thus reduces the effort on finding the needed information for a specific issue in a concrete context.

Well-defined software development processes are rare established. This especially is true for agile software development processes, which become more and more popular. The paper evaluates how far agile software developing processes can be seen as a kind of business processes. This forms the basis for the selective transferring of methods and tools from the field of business processes to the field of software development processes.

- Schwittek, Widura; Eicker, Stefan: Communicating Architectural Knowledge - Requirements for Software Architecture Knowledge Management Tools. In: Muhammad Ali Babar, Ian Gorton (Ed.): Proceedings of the 4th European Conference on Software Architecture (ECSA 2010). Springer-Verlag, Berlin, Heidelberg 2010, p. 457-463. doi:10.1007/978-3-642-15114-9_41CitationAbstractDetails

Architecting is a communication intensive task in which architectural knowledge is shared between the architect and the stakeholders. The software architect’s communicative action is often conducted face-to-face, e.g. in presentations and workshops. A software architecture documentation as a carrier of explicit architectural knowledge can also be seen as an architect’s communicative action. This perspective opens the door for treating a software architecture documentation as an expression of an asynchronous knowledge communication process enabling the application of principles from communication theory. In this paper this perspective is taken and specific requirements are derived for software architecture knowledge management tools with respect to the contextoriented communication model.

- Spies, Thorsten; Hofmann, Thomas: Usability eines 3D-Interfaces zur Visualisierung von Informationssystemlandschaften. In: GfA, Gesellschaft Für Arbeitswissenschaft E. V. (Ed.): Neue Arbeits- und Lebenswelten gestalten, 56. Kongress der Gesellschaft für Arbeitswissenschaft. GfA Press, Darmstadt 2010, p. 239-242. CitationAbstractDetails

Die Informationsvisualisierung trägt dazu bei, die Entwicklung und Wartung von Softwaresystemen und insbesondere die Beherrschung der Systemkomplexität zu erleichtern. Einzelne Softwaresysteme werden durch fortgeschrittene technologische Möglichkeiten immer weiter zu hochintegrierten Informationssystemlandschaften vernetzt, die einem stark dynamischen Umfeld mit nicht mehr vorhersehbaren Wechselwirkungen unterliegen. Der vorliegende Beitrag beschäftigt sich mit der Usability von 3D-Interfaces zur Visualisierung solcher Systemlandschaften.

Dabei gilt es insbesondere, die Nutzerfreundlichkeit der Darstellung von, sowie der Interaktion mit Massendaten und Systemstrukturen zu berücksichtigen. Die Herausforderungen beim Design dreidimensionaler Sichten liegen vor allem in der Architektur der Elemente durch geeignete Layout-Konzepte, der Darstellung visueller Elemente für unterschiedliche Zielgruppen sowie dem Mapping von logischen auf visuelle Dimensionen und Merkmale. Im Speziellen wird der Fokus auf die Interaktions- und Navigationsmöglichkeiten durch die Nutzer gerichtet.

Zur Evaluierung dieser Interaktions- und Visualisierungskonzepte steht ein 3D-Prototyp auf Basis des sogenannten „Generic View“ Konzeptes zur Verfügung. Dieser ermöglicht es, zahlreiche kontextspezifische Sichten auf Informationssystemlandschaften unter Berücksichtigung von Relevanzkriterien einzelner Nutzer „just-in-time“ zu erzeugen.

Die Entwicklungen zeigen, dass auf Basis dreidimensionaler Darstellungsformen andere Qualitäten bezüglich der Visualisierung und Interaktion erzielt werden können. So ist es bspw. möglich Abhängigkeiten unterschiedlicher Elemente über verschiedene Abstraktionsebene hinweg darzustellen. Des Weiteren kann durch innovative Interaktionsformen der kognitive

Workload bei der Systemanalyse reduziert werden. - Eicker, Stefan; Pniewski, Sabine; Schuler, Peter M.: Hard Facts, Soft Skills? Business Informatics Curricula Reviewed for Supporting a Holistic View on People, IT & Organization. In: Miguel Baptista Nunes, Pedro Isaías; Powell, Philip (Ed.): Proceedings of the IADIS International Conference Information Systems 2010. Porto, Portugal 2010. CitationAbstractDetails

With regard to increasing interdependencies between people, IT and organization the demand for intermediation within this area of tension rises. The question is, to what extent the current profile of Business Informatics practitioners is suited to meet this demand. In order to find an answer to this question, we analyzed the current profile of Business Informatics using a structuring model. Based on the results showing both existing and missing hard and soft facets of the profile we suggest possible building blocks for the curricula of an alternative Business Informatics profile.

- Eicker, Stefan; Nagel, Annett; Schuler, Peter M.: Operationalization of Flexibility in Business Process Management. In: Miguel Baptista Nunes, Pedro Isaías; Powell, Philip (Ed.): Proceedings of the IADIS International Conference Information Systems 2010. Porto, Portugal 2010. Full textCitationAbstractDetails

Flexibility is the argument brought forward when preparing enterprises for the (uncertain) future. As business process management (BPM) aims at the methodical design of goal-oriented business processes, the world of change added 'flexibility' to the existing goals 'quality', 'time' and 'costs'. This paper addresses the topic of flexibility focusing on BPM in order to establish a definition of flexibility suited to serve the different research areas, so far each covering flexibility with a particular view. Based on the three levels of flexibility presented in this paper an approach will be documented how business processes can be improved using these levels.

1. EXECUTIVE SUMMARY

This paper discusses the use of existing and new microformats for semantic injection of institutional websites in order to make their valuable information more accessible to students – directly via client tools or indirectly via information portals.

1.1. Background

The Bologna process increased the demand for information on degree programmes. The Faculty of Business Administration and Economics at University of Duisburg-Essen uses two higher-educationspecific content management solutions to satisfy this (and other) information demands by web-based course catalogues.

Thanks to pan-European standardized degrees students may face a wide market for degree programmes. In the best case institutional websites present detailed information on degree programmes and related information in an intuitive way. Of course additional effort is necessary to compare different universities, their academics and degrees due to a lack of consistency and homogeneity.

Microformats as a semantic technology enable the markup of existing websites and thus create semantically rich information. Since the two systems at the Faculty of Business Administration and economics are template based, inserting microformats seems an easily applicable solution – suitable microformats assumed.

1.2. Focus

After discussing the problem statement and introducing the concept of microformats the paper firstly presents the analysis of existing microformats for the given scenario. Secondly Metadata for Learning Opportunities (MLO) is reviewed as a possible blueprint for the semantic structure of course information to design new microformats for higher education. Thirdly scenarios for the future usage of these microformats in form of new application concepts for access of course related information are presented: web browser add-ons understanding the semantic, client tools retrieving the embedded semantic without the indirection via a web browser (e.g. a course catalogue reader for smart phones) and information portals retrieving semantically enhanced information of institutional websites from different universities for comparing their degree programmes.

1.3. Conclusion

This paper closes with a reflection of the approach, the current state of the analysis, possible alternatives and open work items.<span id="1252314128046S"> <span id="1252314278278S"> </span>

</span>1. EXECUTIVE SUMMARY

This paper discusses the use of existing and new microformats for semantic injection of institutional websites in order to make their valuable information more accessible to students – directly via client tools or indirectly via information portals.

1.1. Background

The Bologna process increased the demand for information on degree programmes. The Faculty of Business Administration and Economics at University of Duisburg-Essen uses two higher-educationspecific content management solutions to satisfy this (and other) information demands by web-based course catalogues.

Thanks to pan-European standardized degrees students may face a wide market for degree programmes. In the best case institutional websites present detailed information on degree programmes and related information in an intuitive way. Of course additional effort is necessary to compare different universities, their academics and degrees due to a lack of consistency and homogeneity.

Microformats as a semantic technology enable the markup of existing websites and thus create semantically rich information. Since the two systems at the Faculty of Business Administration and economics are template based, inserting microformats seems an easily applicable solution – suitable microformats assumed.

1.2. Focus

After discussing the problem statement and introducing the concept of microformats the paper firstly presents the analysis of existing microformats for the given scenario. Secondly Metadata for Learning Opportunities (MLO) is reviewed as a possible blueprint for the semantic structure of course information to design new microformats for higher education. Thirdly scenarios for the future usage of these microformats in form of new application concepts for access of course related information are presented: web browser add-ons understanding the semantic, client tools retrieving the embedded semantic without the indirection via a web browser (e.g. a course catalogue reader for smart phones) and information portals retrieving semantically enhanced information of institutional websites from different universities for comparing their degree programmes.

1.3. Conclusion

This paper closes with a reflection of the approach, the current state of the analysis, possible alternatives and open work items.<span id="1252314128046S"> <span id="1252314278278S"> </span>

</span>- Eicker, Stefan; Jung, Reinhard; Schwittek, Widura; Spies, Thorsten: SOA Generic Views - In the Eye of the Beholder. In: Proceedings of the 2008 IEEE International Conference on Services Computing (SCC 2008), IEEE Congress on Services 2008, WebX 2008 Workshop. IEEE, Hawaii, USA 2008, p. 479-486. doi:10.1109/SERVICES-1.2008.102CitationAbstractDetails

This paper presents an approach called Generic View Concept which facilitates the creation and visualization of role-based, task-oriented views on service-oriented architectures. Those views enhance the understanding from the technical and functional point of view, and thus reduce the inherent complexity arising during the creation, use and maintenance of service-oriented architectures. The unique aspect of the Generic View Concept is that it does not constrain stakeholders to a set of predefined views. In order to examine the usefulness of Generic Views in real world scenarios, a prototype has been implemented applying 3D visualization techniques.

1. EXECUTIVE SUMMARY

This paper addresses the problems in information management on modularized courses in an interdisciplinary working department. After this, the general system design goals of bolognaT3 are introduced, which is a web based, centralized system for the management of course catalogues at the Faculty of Business Administration and Economics at the University of Duisburg-Essen. The success factors of the system and the rollout-project conclude the article.

1.1. Background

Universities in Europe and especially in Germany are facing new conditions due to the Bologna process and the introduction of tuition fees. The Bologna process – intending to make the degrees of universities comparable – requires new structures for study programmes. The introduction of tuition fees – intending to lift the quality of the education by financing a portion of the costs through students – makes students to customers. The first causes a higher need for information guiding students and staff to the new way of studying. The second causes students to request better services and correct information anywhere and anytime. The competition between universities in Europe is hereby no longer only about reputation and academics but also on student service and the use of modern information technologies.

The design of study programmes and academics in German universities are under decentralise control of the departments. The need to create new study courses and to change the structure and content of existing ones results in a high information demand by the committees responsible. The necessary information is often neither available in a central system nor in a formal matter. Often enough some of the information is hidden inside exam regulations at the exam office or inside the content of a lecture.

Once the information is collected it is seldom kept up to date, because there is no possibility to easily look up which information is used where. Especially in departments with interdisciplinary courses which make use of the exchangeability of course modules there is a need to overcome problems of redundancy and out-dated information.

1.2. Conclusions

Existing university systems and processes did not fit the need for structured information and information reuse on the one hand and detailed and configurable views on this information for web and print on the other hand. So a new system was necessary that would overcome the problems presented. The TYPO3 based system bolognaT3 was chosen for this purpose.<span id="1252314076270S"><span id="1252314325711S"> </span></span>

1. EXECUTIVE SUMMARY

This paper addresses the problems in information management on modularized courses in an interdisciplinary working department. After this, the general system design goals of bolognaT3 are introduced, which is a web based, centralized system for the management of course catalogues at the Faculty of Business Administration and Economics at the University of Duisburg-Essen. The success factors of the system and the rollout-project conclude the article.

1.1. Background

Universities in Europe and especially in Germany are facing new conditions due to the Bologna process and the introduction of tuition fees. The Bologna process – intending to make the degrees of universities comparable – requires new structures for study programmes. The introduction of tuition fees – intending to lift the quality of the education by financing a portion of the costs through students – makes students to customers. The first causes a higher need for information guiding students and staff to the new way of studying. The second causes students to request better services and correct information anywhere and anytime. The competition between universities in Europe is hereby no longer only about reputation and academics but also on student service and the use of modern information technologies.

The design of study programmes and academics in German universities are under decentralise control of the departments. The need to create new study courses and to change the structure and content of existing ones results in a high information demand by the committees responsible. The necessary information is often neither available in a central system nor in a formal matter. Often enough some of the information is hidden inside exam regulations at the exam office or inside the content of a lecture.

Once the information is collected it is seldom kept up to date, because there is no possibility to easily look up which information is used where. Especially in departments with interdisciplinary courses which make use of the exchangeability of course modules there is a need to overcome problems of redundancy and out-dated information.

1.2. Conclusions

Existing university systems and processes did not fit the need for structured information and information reuse on the one hand and detailed and configurable views on this information for web and print on the other hand. So a new system was necessary that would overcome the problems presented. The TYPO3 based system bolognaT3 was chosen for this purpose.<span id="1252314076270S"><span id="1252314325711S"> </span></span>

Der Artikel fasst die Ergebnisse einer von der Universität Duisburg-Essen in Zusammenarbeit mit der Materna GmbH durchgeführten Untersuchung zusammen. Analysiert wurde, welche Auswirkungen eine Erhöhung des Service Level einer Service Level-Kennzahl jeweils auf die verschiedenen Kostenarten besitzt. Hierzu wurden zunächst die relevanten Kostenarten ermittelt sowie eine spezielle grafische Notation für die Ergebnisdarstellung entworfen. Die Untersuchung zeigt, wie das IT-Controlling wertvolle Informationen für die Gestaltung von Service-Verträgen ermitteln kann.

- Eicker, Stefan; Heimann, Erik; Bucksteeg, Martin: Kostenabhängigkeitsbetrachtung für Service Levels von Managed Desktop Services am Beispiel der Verfügbarkeit. In: Bichler, Martin; Hess, Thomas; Krcmar, Helmut; Lechner, Ulrike; Matthes, Florian; Arnold, Picot; Speitkamp, Benjamin; Wolf, Petra (Ed.): Multikonferenz Wirtschaftsinformatik 2008. Gito, Berlin 2008, p. 213-217. CitationAbstractDetails

Der vorliegende Beitrag zeigt zunächst kurz die Notwendigkeit der Untersuchung der Kostenstruktur von Service Levels sowohl aus Sicht der IT-Dienstleister als auch der Kunden auf. Für ein spezielles IT-Service-Szenario, die so genannten Managed Desktop Services (MDS), werden dann eine IT-Kostenstruktur sowie Service Level-Kennzahlen vorgestellt. Schließlich wird auf der Basis der Diskussion in der Literatur ein Ansatz für die Analyse der Abhängigkeiten von Service Levels und den zugehörigen Kosten vorgestellt und exemplarisch auf die Service Level-Kennzahl Verfügbarkeit von MDS angewendet.

- Eicker, Stefan; Heimann, Erik; Zimmermann, Carsten: Das Potenzial der Referenzmodelle ITIL und CobiT für die IT-Governance. In: Bichler, Martin; Hess, Thomas; Krcmar, Helmut; Lechner, Ulrike; Matthes, Florian; Picot, Arnold; Speitkamp, Benjamin; Wolf, Petra (Ed.): Multikonferenz Wirtschaftsinformatik 2008. Gito, Berlin 2008. CitationDetails

Die jüngeren Entwicklungen der Informations- und Kommunikationstechnik haben zu einer mehr und mehr globalisierten Welt geführt, in der geographische Beschränkungen entfallen und sich Unternehmen ständig neuen Herausforderungen gegenübergestellt sehen. Ein solch dynamisches Umfeld erfordert, dass sich Unternehmen an geänderte Bedingungen anpassen können – d. h. sie müssen flexibel sein. Geschäftsprozessmanagement (GPM) ermöglicht eine zielgerichtete Steuerung der Geschäftsprozesse und damit des Unternehmens. Unter der Zielsetzung des Erfolgsfaktors „Flexibilität“ untersucht der vorliegende Arbeitsbericht die Gestaltungsmöglichkeiten innerhalb des GPM.

Durch die wachsende Bedeutung von Softwaresystemen (Stichwort: „Softwareintensive Systeme“) beeinflusst die Softwareindustrie zunehmend auch andere Industriezweige. Aber obwohl sie sich damit zu einer „Leitindustrie“ entwickelt hat, befindet sich ihre Entwicklung - zumindest im Vergleich zu anderen Industrien - noch in einem relativ unreifen Stadium. Angesichts der immer härteren Rahmenbedingungen, die sich insbesondere in einem hohen Termindruck, Budgetrestriktionen, einem dynamischen Umfeld und in der steigenden Komplexität von Software ausdrücken, ist eine Professionalisierung der Entwicklungsmethodik aber zwingend erforderlich, auch, um eine Verschlechterung der Produktqualität zu vermeiden. Das Voranschreiten der Industrialisierung der Softwareentwicklung bildet somit eine zentrale Herausforderung für die Softwarebranche. Im vorliegenden Beitrag wird zur Verbesserung der Möglichkeiten eines kontinuierlichen Monitorings von Softwareprojekten eine Methode vorgestellt, die eine Aussage über die „Reife“ des aktuellen Entwicklungsstands einer Software ermöglicht. Das Ziel der Methode besteht darin, die Eigenschaften der Produktqualität transparent zu machen, um auch unter den sich verschärfenden Rahmenbedingungen qualitativ hochwertige Software entwickeln zu können. Den Bewertungsgegenstand der Methode bildet demzufolge nicht – wie bei vielen Ansätzen - der zugrunde liegende Entwicklungsprozess, sondern das zu entwickelnde Produkt, die Software. Als Vergleichsmethodik wird in dem Beitrag die „Reifegrad-Absicherung für Neuteile“ vom Verband der Automobilindustrie (VDA) herangezogen, da dieses Verfahren das konsolidierte Ergebnis in einem Industriezweig darstellt, der im Zuge der Industrialisierung eine kontinuierliche Verbesserung von Prozessen und Methoden erfahren hat.

- Eicker, Stefan; Spies, Thorsten; Kahl, Christian: Software Visualization in the Context of Service-Oriented Architectures. In: Proceedings of the 4th IEEE International Workshop on Visualizing Software for Understanding and Analysis (Vissoft2007). IEEE, Banff, Alberta, Canada 2007, p. 108-111. doi:10.1109/VISSOF.2007.4290708Full textCitationAbstractDetails

Software visualization contributes to the support and maintenance of software systems, especially to alleviating the handling of a systems’ complexity. This article deals with approaches to visualization in the context of service-oriented architectures, which allow the building of flexible system environments, but which are nevertheless subject to a dynamic outer field. Thus a distinctive understanding both from the technological and from the functional point of view is an important prerequisite for a successful implementation of such systems. The following article presents a concept of three-dimensional views as well as the development of a visualization pipeline to create dynamic views. These approaches provide the stakeholders with access to relevant information which can then be integrated into the over-all context.

The delayed delivery of the AIRBUS A380© demonstrates the challenges to be faced in the field of cross-company collaboration today. On the one hand, available CWE platforms are used insufficiently. On the other hand, they do not yet support collaboration in a completely adequate way. This paper illustrates the current state of CWE practice by way of a sample company, its internal and external collaboration processes and the services used. Improvements provided by major vendors in the domain of commercial CWE platforms and the current techniques of Web-2.0 are analysed with regard to the concept of contextbased communities that ought to be applied within any CWE efforts according to this paper.

Die Softwarearchitektur eines Anwendungssystems besitzt einen erheblichen Einfluss auf die Qualitätsmerkmale des Gesamtsystems. Sie stellt somit einen kritischen Erfolgsfaktor sowohl für die Entwicklungs- als auch für die Nutzungsphase des Systems dar. In einem Softwareentwicklungsprojekt muss deahlb eine dedizierte und dataillierte Betrachtung der softwarearchitektur erfolgen. Zur Bewertung einer Softwarearchitektur im Kontext eines konkreten Projektes ist eine Vielzahl von Bewertungsmethoden mit unterschiedlichen Eigenschaften entwickelt worden. Der vorliegende Beitrag beschäftigt sich mit der Auswahl einer geeigneten Methode für ein Projekt; er stellt dazu eine Taxonomie und darauf aufbauend einen strukturierten Auswahlprozess vor.

Die Softwarevisualisierung trägt dazu bei, die Entwicklung und Wartung von Softwaresystemen und insbesondere die Beherrschung der Systemkomplexität zu erleichtern. Der vorliegende Beitrag beschäftigt sich mit Visualisierungsansätzen im Kontext serviceorientierter Architekturen. Die Architekturen erlauben es, flexible Systemlandschaften zu schaffen, unterliegen jedoch einem stark dynamischen Umfeld. Deshalb bildet ein ausgeprägtes Verständnis sowohl aus technologischer als auch aus fachlicher Sicht einen wesentlichen Erfolgsfaktor bei der Einführung der Systeme. Im Folgenden wird dazu die Konzeption dreidimensionaler Sichten und die Entwicklung einer Visualisierungspipeline zur Erzeugung dynamischer Views vorgestellt. Die Ansätze bieten den unterschiedlichen Stakeholdern jeweils die Möglichkeit, die für sie relevanten Informationen abzurufen und in den Gesamtkontext einzuordnen.

Silvester 1999 zogen die ganz Vorsichtigen mit Eiserner Ration und Transistorradio in den Bunker. Schlag Mitternacht, so hatten die Apokalyptiker prophezeit, würden nahezu alle Computerprogramme auf dem Globus ihren Dienst versagen. Chaos, wirtschaftlicher Zusammenbruch und womöglich der Dritte Weltkrieg wären die Folgen. Neurotisches Verhalten auch bei der Einführung der gemeinsamen Währung Anfang 2002. Mancher traute den Computern der Banken die korrekte Division durch 1,95583 nicht zu und räumte vor dem Jahreswechsel sicherheitshalber das Konto ab. In beiden Fällen erwiesen sich die elektronischen Informationssysteme – bis auf ein paar Ausreißer – als ausreichend anpassungsfähig. Abseits derart prominenter Ereignisse werden in Unternehmen und Verwaltungen ständig und teilweise in großem Umfang Anpassungen an den eingesetzten Informations- und Kommunikationssystemen durchgeführt. Meist mit erheblichem Aufwand und nicht immer mit dem gewünschten Erfolg. Der Lehrstuhl für Wirtschaftsinformatik und Softwaretechnik an der Universität Duisburg-Essen arbeitet deshalb an betrieblichen Anwendungssystemen, die die notwendige Flexibilität von Anfang an mitbringen.

- Ackermann, Ulf; Eicker, Stefan; Neuhaus, Sebastian; Schuler, Peter M.: Das EPA-Modell - Ein Referenzmodell für prozessorientierte, dienstbasierte Unternehmensarchitekturen. In: Lehner, F.; Nösekabel, H.; Kleinschmidt, P. (Ed.): Multikonferenz Wirtschaftsinformatik 2006, Tagungsband 2. GITO-Verlag, Berlin 2006, p. 183-197. PDFCitationAbstractDetails

Die IT-Landschaft vieler Unternehmen besteht aus heterogenen und inkompatiblen Einzelsystemen, deren Betrieb unverhältnismäßig hohe Kosten verursacht. Als Ursache dieser Integrationsproblematik identifiziert DAVENPORT die Fragmentierung der Informationen in großen Unternehmen. Verschiedene Lösungsansätze (EAI, SOA, GPM) versuchen diese Integrationsproblematik zu lösen. Jedoch beeinflussen die Ursachen ("changes in the marketplace, and strategic restructurings, through acquisitions, divestitures, and partnerships") kontinuierlich die Unternehmen - unabhängig vom bestehenden Grad der Integration. Anbieter von Unternehmenssoftware preisen als Lösung vermehrt serviceorientierte Lösungen an. Das EPA-Modell wurde entworfen, um eine umfassende Sicht auf die Integrationskonzepte für Unternehmenssysteme zu entwickeln. Die unterschiedlichen Integrationsansätze wurden dazu analysiert und in ein ganzheitliches Modell überführt. Der Name des Modells steht in Anlehnung an die Enterprise Service Architecture (ESA) für Enterprise Process Architecture (EPA).

Im Kontext der fortschreitenden Globalisierung müssen nicht nur Großunternehmen, sondern auch kleine und mittlere Unternehmen (KMU) ihre Geschäftsstrategien auf internationale Märkte ausrichten. Wesentliches Charakteristikum dieser Märkte ist ihre ausgeprägte Dynamik, die von den Unternehmen eine entsprechend hohe Anpassungsfähigkeit erfordert. Diese setzt auf der operationalen Ebene flexible IT-Architekturen und -Anwendungen voraus, in denen Prozesse, Produkte und Dienstleistungen dynamisch auf die jeweiligen Anforderungen anpassbar abgebildet sind. Gegenstand des Forschungsprojekts ist deshalb die Entwicklung eines generischen Vorgehensmodells zum Aufbau einer flexiblen unternehmensweiten IT-Architektur im Rahmen von Migrations-, Integrations- und Refactoring-Projekten. ?Generisch? heißt dabei zum einen, dass das Modell einen Rahmenprozess mit entsprechenden Phasen und Aktivitäten definiert, der jeweils im Hinblick auf die konkreten Anforderungen eines Unternehmens sowie im Hinblick auf die durchzuführenden Teilprojekte ?instanziiert? wird. Zum anderen soll das Modell einen Fundus von Lösungsansätzen für die Durchführung der Teilprozesse und Aktivitäten in Gestalt von Leitfäden, Patterns und Best Practices bieten, aus denen jeweils die im konkreten Fall zu nutzenden Ansätze über entsprechende Bewertungskriterien ausgewählt werden. Das Vorgehensmodell soll in den konkreten Projekten der Ariadne-Community validiert und sukzessiv verfeinert werden.

- Adelsberger, H.; Eicker, S.; Krcmar, H.; Pawlowski, J. M.; Pohl, K.; Rombach, D.; Wulf, V. (Ed.): Multikonferenz Wirtschaftsinformatik 2004 - Band 1: E-Learning: Modelle, Instrumente und Erfahrungen, Software-Produktlinien, Communities im E-Business, Akademische Verlagsgesellschaft Aka GmbH, Berlin 2004 (ISBN: 3-89838-049-1). CitationDetails

- Eicker, Stefan; Lambertz, Thorsten; Lelke, Frank: Analyse eines SAP BW-Einsatzes im Controlling am Beispiel der T-Com. In: Schelp, J.; Winter, R. (Ed.): Auf dem Weg zur Integration Factory - Proceedings der DW2004 - Data Warehousing und EAI. Physica-Verlag, Heidelberg 2004. doi:10.1007/3-7908-1612-4_22CitationAbstractDetails

Die T-Com zählt mit ca. 58 Mio. Anschlüssen zu den größten Festnetzanbietern Europas. Im Konzernverbund der Deutschen Telekom AG bildet die T-Com eine von insgesamt vier Konzerndivisionen (T-Mobile, T-Online, T-Systems, T-Com). Vor Einführung des unternehmensweiten Data Warehousing existierten im Konzern ca. 30 verschiedene dispositive Informationssysteme, die Daten aus internen Vorsystemen und externen Quellen verarbeiteten. Durch Einführung eines oder mehrerer Data Warehouses sollten integrierte und konsistente Datenbasen geschaffen werden, die für die verschiedenen dispositiven Anwendungen genutzt werden konnten (Single-Sourcing-Prinzip). Die Anzahl der Schnittstellen zu den operativen Vorsystemen sollte gesenkt werden – und mit ihnen auch der Administrationsaufwand. Durch sukzessiven Aufbau einer Data-Warehouse-Landschaft passte die T-Com ihre Systemlandschaft an die genannten Anforderungen sowie auch an veränderte bzw. neue betriebswirtschaftliche Anforderungen an. Im Laufe der Zeit entstanden vier unabhängige Data Warehouses (DWHs) für unterschiedliche Anwendungsbereiche. Für die sukzessiv geschaffene Landschaft mit ihren vier Datenbasen stellt sich die Frage, inwieweit die gesteckten Ziele erreicht wurden und ob über die ursprünglich

geplanten und realisierten Anwendungsfelder hinaus weitere, latente Anwendungspotenziale aufgedeckt und erschlossen werden können. Im Rahmen einer Diplomarbeit wurde dieser Frage mit dem Fokus auf einem bei der T-Com eingesetzten SAP BW nachgegangen. Auf den unteren Ebenen des ISO/OSI-Protokoll-Stacks existieren zahlreiche Ansätze zur Lokalisierung von Diensten; die Ansätze finden auch verbreitet Anwendung in modernen Netzen. Trading, d.h. eine Lokalisierung von Diensten auf der Anwendungsebene, besitzt dagegen bisher kaum praktische Relevanz. Dies ist nicht zuletzt darauf zurückzuführen, dass der entsprechende ODPTrading-Standard und alle darauf aufbauenden Standards und Implementierungen gravierende Schwächen aufweisen; zu nennen sind u.a. die fehlende Unterstützung von Softwarekomponenten, die fehlende semantische Beschreibung von Diensten sowie Defizite bezüglich der Architektur des Traders. Im vorliegenden Beitrag wird mit dem Universal Component Trading (UComT) ein Konzept zur Vermittlung von Softwarekomponenten vorgestellt, die aus verschiedenen Komponentenmodellen stammen können. Im Gegensatz zum ODP-Trading-Standard unterstützt das UComT-Konzept auch unterschiedliche Handelseinheiten, unterschiedliche Beschreibungs- und Suchsprachen sowie unterschiedliche Zugriffsprotokolle innerhalb eines Traders. Dies wurde insbesondere durch eine modulare Trader-Architektur und durch Einsatz der Standard-Beschreibungssprache XML erreicht.

In den vergangenen Jahren hat der Einsatz des server-based Computing (SBC) aufgrund der im Vergleich zu etablierten Client-Server-Architekturen niedrigeren Total Costs of Ownership in betrieblichen Umgebungen immer mehr an Attraktivität gewonnen. Die Kombination von SBC und virtuellen Maschinen (VM) im E-Learning ermöglicht den Aufbau virtueller Computerpools, auf die die Lernenden über das Internet zugreifen. Der vorliegende Artikel skizziert die technischen Grundlagen und schildert erste Erfahrungen aus dem Einsatz virtueller Computerpools an der Virtual Global University (VGU).

- Eicker, S. (Ed.): E-Learning: Modelle, Instrumente und Erfahrungen - Tagungsband der Teil-Konferenz E-Learning im Rahmen der Multikonferenz Wirtschaftsinformatik (MKWI02), Nürnberg 2002. CitationDetails

- Eicker, Stefan; Schüngel, Martin: Stand der Unternehmensdatenmodellierung in der Praxis. In: Information Management & Consulting, Vol 13 (2002) No 4, p. 78-85. CitationDetails

Clearing via Internet: Die Rechnungsstellung und -bezahlung über das Internet ist eine kostengünstige und komfortable Alternative zum traditionellen Postweg.

Was sind die Vor- und Nachteile dieses Verfahrens? Eine Reise in die Zukunft des E-Billing rundet den Beitrag mit einem virtuellen Szenario ab.

- Eicker, Stefan: Ein Überblick über die Umsetzung des Data Warehouse-Konzepts aus technischer Sicht. In: Holten, R.; Schütte, R.; Rotthowe, T. (Ed.): Data Warehouse Managementhandbuch. Konzepte, Software, Erfahrungen.. Springer-Verlag, Berlin 2001, p. 65-79. doi:10.1007/978-3-642-56847-3_4CitationAbstractDetails

Die Realisierung eines Management-Informationssysterns durch ein Data Warehouse erfordert grundsätzlich — wie auch bei anderen cornputergestutzten betrieblichen Information ssystemen — einen Systemplanungs- und -entwicklungsprozess. 1m Rahmen des Prozesses sind die Komponenten für die verschiedenen Ebenen der Architektur für Management-Inforrnationssysterne zu planen, zu realisieren, zu testen und schließlich einzuführen.

- Eicker, Stefan; Schwichtenberg, Holger; Büning, Wolfgang: Ein Framework für Shop-Systeme auf Basis der Java 2 Enterprise Edition. In: Buhl, H. U.; Huther, A.; Reitwiesner, B. (Ed.): Wirtschaftsinformatik 2001. Physica-Verlag, Heidelberg 2001, p. 637-650. doi:10.1007/978-3-642-57547-1_56CitationAbstractDetails

Insbesondere kleine und mittelständische Unternehmen können oder wollen für ihren Eintritt in die eCommerce-Welt häufig nur sehr begrenzte Mittel bereitstellen. Auf der anderen Seite können statische Web-Anwendungen Unternehmen allenfalls einen geringen Nutzen bringen. Die Entwicklung dynamischer Web-Anwendungen deren Seiten aus aktuellen Datenbankinhalten generiert werden erfordert jedoch zumeist einen erheblichen Entwicklungsaufwand. Ein Weg den Aufwand signifikant zu senken besteht in der Standardisierung. Damit sich die Auftritte der verschiedenen Unternehmen unterscheidendarf ein Standardsystem allerdings nur einen Rahmen vorgeben der die grundlegende Funktionalität umfasst und beim konkreten Einsatz an die spezifischen Anforderungen angepasst werden kann. In dem Beitrag wird ein solches Standardsystem in Gestalt eines Frameworks für internetbasierte Warenkorbsysteme (Online-Shops) vorgestellt. Es stellt das Ergebnis einer Machbarkeitsstudie dar in der die Möglichkeit eruiert wurde auf der Basis einer kostengünstigen Plattform ein Standard-Warenkorbsystem zu entwickeln das die hohen zu erfüllenden Anforderungen an Skalierbarkeit und Verfügbarkeit erfüllen kann und das möglichst geringe zusätzliche Kenntnisse der Web-Designer erfordert.

- Eicker, Stefan; Nietsch, Michael: Standards zum objektorientierten Paradigma. In: Wirtschaftsinformatik, Vol 41 (1999) No 4, p. 358-370. doi:10.1007/BF03250665CitationAbstractDetails

Software muß sicherer, austauschbarer, granularer und unabhängiger werden, ihre Entwicklung effizienter und besser kalkulierbar. Der objektorientierte Ansatz verspricht, diese Anforderungen besser zu erfüllen als traditionelle Ansätze. <br><br>Der Beitrag skizziert den State of the Art der Standards zur Objekttechnik. Betrachtet werden Standardisierungsorganisationen im Umfeld der Objektorientierung, Vorgehensweisen für die OO-Softwareentwicklung, die UML als grafische Beschreibungssprache für Softwareartefakte sowie Ansätze zum Modeling by Difference. Im Bereich der OO-Implementierung werden die Themen Kommunikationsinfrastruktur/Middleware, Datenhaltung und Programmiersprache behandelt.

- Eicker, Stefan; Schwichtenberg, Holger: Electronic Bill Presentment and Payment als neue Form des Electronic Billing. In: Scheer, A. W.; Nüttgens, M. (Ed.): Wirtschaftsinformatik 1999. Physica-Verlag, Heidelberg 1999, p. 147-167. doi:10.1007/978-3-642-58663-7_10CitationAbstractDetails

In einem Projekt wurde für ein großes Telekommunikationsunternehmen die Möglichkeit untersucht, das Internet für den Versand und die Bezahlung von Rechnungen zu nutzen. Der vorliegende Beitrag faßt die Ergebnisse der Untersuchung zusammen: Aufbauend auf einer Betrachtung der Grundlagen der Rechnungsstellung und bestehender Billing-Verfahren präsentiert er das Web-Billing, das E-Mail-Billing und die Bill Consolidation als Lösungsansätze für das Internet Bill Presentment and Payment (IBPP). Die Ansätze werden insbesondere im Hinblick auf die Erfüllung der Anforderungen von Rechnungssteiler und Rechnungsempfanger sowie auch aus juristischer Sicht diskutiert. Aus der für das Telekommunikationsunternehmen entwickelten Konzeption für ein IBPP-System stellt der Beitrag die Systemarchitektur sowie das Bill Presentment der Telekommunikationsrechnung vor.

- Eicker, Stefan; Jung, Reinhard; Nietsch, Michael; Winter, Robert: Development of a Data Warehouse: Concepts and Lessons Learned. In: Journal of Data Warehousing, Vol 3 (1998) No 1, p. 18-28. CitationDetails

- Eicker, Stefan: Management der Ressource "Daten" im Unternehmen unter besonderer Berücksichtigung der integrationsorientierten Datendokumentation. Frankfurt (Oder) 1997. CitationDetails

- Eicker, Stefan; Jung, Reinhard; Nietsch, Michael; Winter, Robert: Entwicklung eines Data Warehouse für das Produktionscontrolling: Konzepte und Erfahrungen. In: Krallmann, H. (Ed.): Wirtschaftsinformatik 1997. Physica-Verlag, Heidelberg 1997, p. 449-468. doi:10.1007/978-3-642-57737-6_27CitationAbstractDetails

Aufgabe eines Data Warehouse ist die schnelle und flexible Bereitstellung entscheidungsrelevanter Daten. Es stellt damit — je nach Interpretation — eine Weiterentwicklung der Entscheidungsunterstützungssysteme oder eine auf Analyseaufgaben ausgerichtete Datenbank dar. Um seine Aufgabe erfüllen zu können, muß ein Data Warehouse heterogene Datenquellen zu einer stabilen, konsistenten Datenbasis zusammenführen, Detaildaten für die analytischen Auswertungen (vor-)verdichten sowie auch zeitraumbezogene Längsschnittanalysen unterstützen. Die Entwicklung eines Warehouse unterscheidet sich deshalb in vielen Punkten von der Entwicklung eines traditionellen, transaktionsorientierten Anwendungssystems. Der folgende Beitrag diskutiert, welche Aufgaben jeweils in den verschiedenen Phasen einer Data Warehouse-Entwicklung anfallen und wie diese Aufgaben durchgeführt werden können. Die vorgestellten Konzepte und Erfahrungen sind Ergebnisse eines Kooperationsprojekts zwischen dem Institut für Wirtschaftsinformatik der Universität Münster und einem großen Maschinenbauunternehmen.

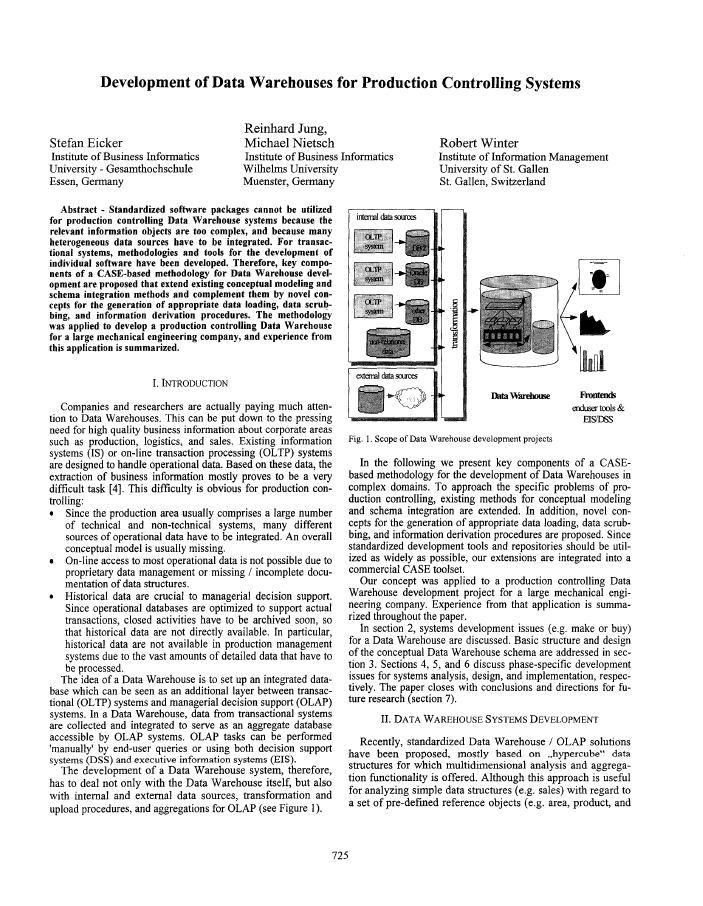

- Eicker, Stefan; Jung, Reinhard; Nietsch, Michael; Winter, Robert: Development of Data Warehouses for Production Controlling Systems. In: Kocaoglu, D. F.; Anderson, T. R. (Ed.): Innovation in Technology Management - The Key to Global Leadership, Proceedings PICMET '97. Portland State University , Portland 1997, p. 725-728. doi:10.1109/PICMET.1997.653595Full textCitationAbstractDetails

Standardized software packages cannot be utilized for production controlling data warehouse systems because the relevant information objects are too complex, and because many heterogeneous data sources have to be integrated. For transactional systems, methodologies and tools for the development of individual software have been developed. Therefore, key components of a CASE-based methodology for data warehouse development are proposed that extend existing conceptual modeling and schema integration methods and complement them by novel concepts for the generation of appropriate data loading, data scrubbing and information derivation procedures. The methodology was applied to develop a production controlling data warehouse for a large mechanical engineering company, and experience from this application is summarized.

- Eicker, Stefan: Daten-Reengineering als Teilaufgabenbereich des Datenmanagements. In: Kracke, U. (Ed.): Datenbanksysteme. Augsburg 1996. CitationDetails

- Eicker, Stefan: Metadatenbanksysteme und Metadatenmanagement. In: Kracke, U. (Ed.): Datenbanksysteme. Augsburg 1996. CitationDetails

- Baumöl, Ulrike; Borchers, Jens; Eicker, Stefan; Hildebrand, Knut; Jung, Reinhard; Lehner, Franz: Einordnung und Terminologie des Software Reengineering. In: Informatik-Spektrum, Vol 19 (1996) No 4, p. 191-195. doi:10.1007/s002870050030CitationAbstractDetails

Der vorliegende Aufsatz ordnet das Software Reengineering in das Software Engineering ein und trifft Festlegungen für die wichtigsten Begriffe des Software Reengineering.Er stellt das Ergebnis einer Arbeitsgruppe der GI-Fachgruppe 5.1.3 „Reengineering und Wartung betrieblicher Anwendungssysteme“ dar.Ziel der Arbeitsgruppe war es, eine einheitliche terminologische Grundlage für Forschung und Praxis zu schaffen.Zu diesem Zweck wurde zunächst die Verwendung der Begriffe in der Literatur untersucht. Darauf aufbauend erfolgte die Formulierung der Definitionen.

- Kurbel, Karl; Eicker, Stefan: Reuse of Information about Legacy Systems for Repository-based IS Development. In: Proceedings of the International Symposium on Systems Research, Informatics and Cybernetics: Information Systems Analysis and Synthesis (ISAS'95). 1995, p. 83-97. CitationDetails

- Eicker, Stefan; Kurbel, Karl: Introduction I-CASE-Technology into Application Development - Experiences and Learning from Projects in an Educational Environment. In: Doukidis, G. : et al. (Ed.): Proceedings of the 3rd European Conference on Information Systems (ECIS '95). Athen 1995, p. 865-877. CitationAbstractDetails

1-CASE (Integrat;d CASE) promises significant productivity gains, but successful use requires profound knowledge ofmethodology and tools. Since both methodology and toolsets are rather complex, it takes time and e:1..-perience to acquire that knowledge. In this paper, we report about our experience with introduction of a comprehensive 1-CASE toolset (ADW) into university education. The process covered two years, starting with tool evaluation and exploration, and first use of tools in courses on IS development, before a pilot project and subsequently a three-person-year productive project were carried out. Tue latter project ended successfully witb code generatiO,n (338,000 lines of code). Tue paper focusses on the learning process the teaching staff·went through. Some insights gained will also hold for industrial 1- CASE use.

- Eicker, Stefan; Schnieder, Thomas: Ziele, Aufgaben und Werkzeuge für das Reengineering. In: Lehner, F. (Ed.): Reengineering und Softwarewartung - Stand der Technik, Erfahrungen und Entwicklungen. Vallendar 1994, p. 51-72. CitationDetails

- Eicker, Stefan: IV-Dictionary - Konzepte zur Verwaltung der betrieblichen Metadaten, Reihe "Studien zur Wirtschaftsinformatik". W. de Gruyter, Berlin et al 1994. (ISBN 3-11-014149-3) CitationDetails

- Eicker, Stefan: Softwareentwicklung und -Reengineering aus der Sicht des Business Process Reengineering. In: Proceedings der Fachtagung MobIS'94. 1994, p. 110-112. CitationDetails

- Kurbel, Karl; Eicker, Stefan; Kersten, Frank; Schnieder, Thomas; Teubner, Alexander: I-CASE bei der Entwicklung eines großen Informationssystems: eine Information-Engineering-Fallstudie. In: Wirtschaftsinformatik, Vol 36 (1994) No 2, p. 130-140. CitationDetails

- Eicker, Stefan: Das Einsatzpotential des Reengineering bei der Entwicklung einer integrierten Anwendungslandschaft. In: Stucky, W.; Oberweis, A. (Ed.): Proceedings des GI-Fachgesprächs "Management der Anwendungsentwicklung und -wartung". Hannover 1994, p. 26-35. CitationDetails

- Eicker, Stefan; Jung, Reinhard: Wirtschaftlichkeit von Reengineering-Projekten. In: v. Dobschätz, L.; Kisting, J.; Schmidt, E. (Ed.): IV-Controlling in der Praxis: Kosten und Nutzen der Informationsverarbeitung. Gabler-Verlag, Wiesbaden 1994, p. 113-131. doi:10.1007/978-3-663-10416-2_7CitationAbstractDetails

Im Laufe der letzten dreißig Jahre hat sich in großen und mittelständischen Unternehmen eine Vielzahl von computergestützten Anwendungssystemen angesammelt. Die Wartung der Systeme bindet einen erheblichen Teil der Personalressourcen in den IV-Abteilungen. Bereits Ende der 70er Jahre kamen zwei Untersuchungen zu dem Ergebnis, daß etwa 50% des IV-Personals für Wartungsarbeiten eingesetzt werden, wobei der Anteil in größeren Unternehmen tendenziell höher ist als in kleinen (Fjeldstadt/Hamlen 1979; Lientz/Swanson 1980). Der heutige Wartungsanteil an den Gesamtaufwendungen für die Daten-verarbeitung wird von der Gartner Group sogar auf über 80% veranschlagt.

- Eicker, Stefan: Verknüpfung der Objekte eines CASE-Repository mit der zugehörigen textlichen Dokumentation. In: HMD, Vol 31 (1994) No 175, p. 106-122. CitationAbstractDetails

Die Existenz einer verständlichen, aussagekräftigen und aktuellen Dokumentation wird heute als wesentliches Qualitätsmerkmal von Softwaresystemen angesehen. Die Erstellung/Anpassung der Dokumentation ist deshalb in der Regel sowohl in Entwicklungsprojekte als auch in Wartungsarbeiten integriert. In bezug auf die unterstützenden Werkzeuge jedoch klafft zwischen den softwaretechnischen Aufgaben auf der einen Seite und der Dokumentierung ihrer Ergebnisse auf der anderen Seite eine Lücke: Für die Sottwareentwicklung werden moderne CASE-Werkzeuge eingesetzt, die Dokumentation wird davon getrennt mit Textverarbeitungssystemen oder speziellen Dokumentationswerkzeugen erzeut. Diese Trennung erhöht den Dokumentationsaufwand und wirft Probleme dahingehend auf, die Verbindung zwischen Dokumenten und dokumentierten Objekten wie Systemen, Programmen, Daten, Masken/Fenstern etc. herzustellen sowie - damit verbunden - die Qualität der Dokumentationen zu gewährleisten.

Der folgende Beitrag skizziert zunächst bestehende Ansätze, die Trennung zwischen den Werkzeugen zu überwinden. Er stellt dann aufbauend auf den beschriebenen Ansätzen selbst ein Konzept vor, durch das Entwicklungsergebnisse und die zugehörige textliche Dokumentation miteinander verknüpft werden können.

- Eicker, Stefan; Jung, Reinhard; Kurbel, Karl: Anwendungssystem-Integration und Verteilungsarchitektur aus der Sicht des Reengineering. In: Informatik - Forschung und Entwicklung (1993) No 8, p. 70-78. CitationDetails

- Eicker, Stefan; Schnieder, Thomas: Integrationsorientiertes Reengineering von Cobol-Altsystemen. In: PIK, Vol 16 (1993) No 3, p. 162-168. CitationDetails

- Eicker, Stefan: Die Informationssystem-Architektur als Teilschema eines zentralen, integrierten Metadatenpools. In: Proceedings der Fachtagung MobIS'93. 1993, p. 9-11. CitationDetails

Die Daten einer Unternehmung stellen eine Infrastruktur dar, die ganzheitlich und nicht anwendungsspezifisch geplant und verwaltet werden sollte. Dies erfordert die Zusammenfassung aller Aufgaben bezüglich der Daten zu einem Aufgabenbereich, der für die aufeinander abgestimmte Planung, Allokierung, Bereitstellung, Erhaltung etc. aller betrieblichen Datenressourcen zuständig ist. Ein solcher Aufgabenbereich wird hier als Datenmanagement bezeichnet.